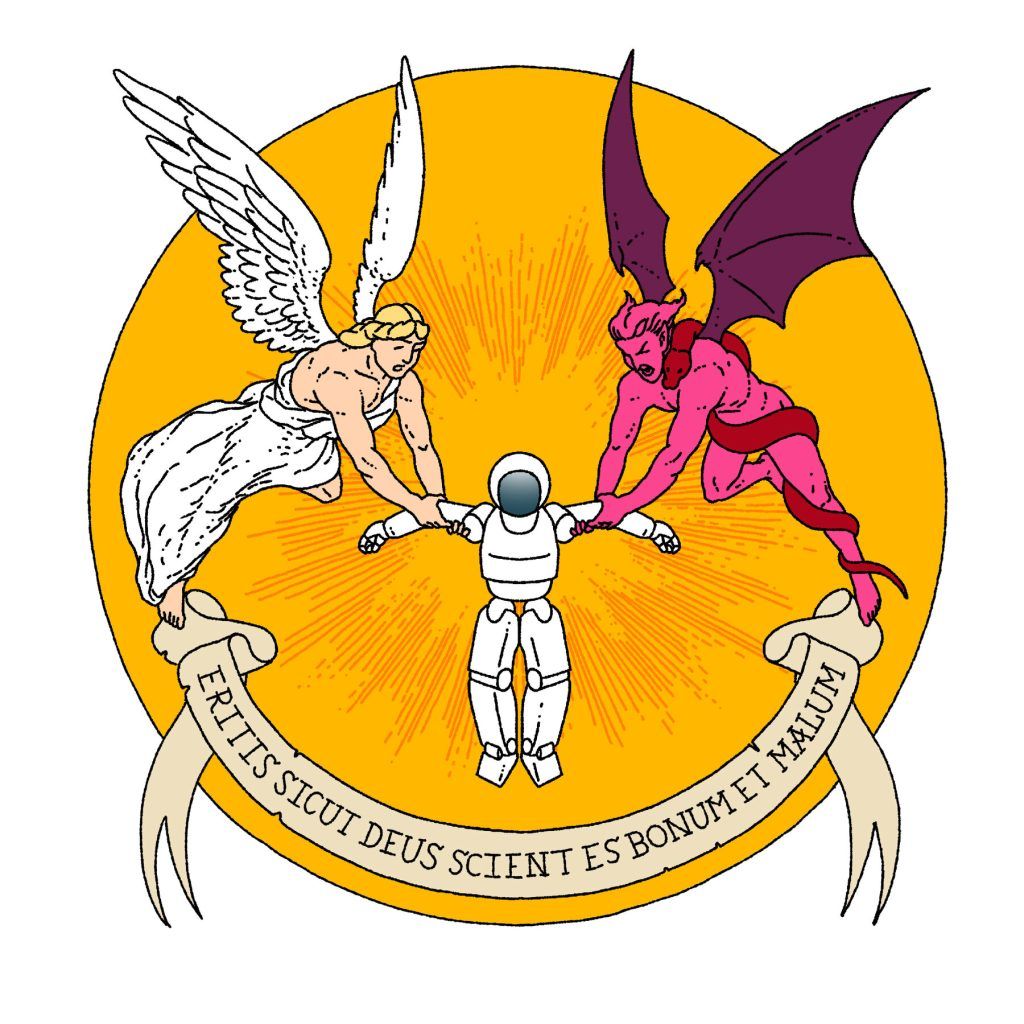

هوش مصنوعی شمشیری دو لبه است. این فناوری هم میتواند فرصتی برای بشر باشد و هم میتواند به تهدید بزرگی برای او تبدیل شود. یکی از سؤالات مهم در حوزه توسعه مسئولانه هوش مصنوعی این است که آیا این فناوری میتواند از نظر اخلاقی درست را از غلط تشخیص دهد یا نه. بررسی توانایی تشخیص سره از ناسره توسط هوش مصنوعی در حیطه پژوهشهای مرتبط با این فناوری اهمیت زیادی دارد. در حقیقت پژوهشگران این سؤال را مطرح کردهاند که آیا هوش مصنوعی میتواند تشخیص درست از غلط را یاد بگیرد؟ آیا هوش مصنوعی میتواند پیچیدگیها اصول اخلاقی و ارزش های انسان را درک کند؟ مثلاً میتواند تشخیص دهد به دقت تشخیص دهد در چه شرایطی افراد باید کشته شوند، یا در چه شرایطی باید آنها را نجات داد

تاکنون متخصصان حوزه هوش مصنوعی در زمینه آموزش هوش مصنوعی برای انجام مهارتهای شناختی مثل تصمیمگیری، نتیجهگیری و درک مفاهیم پیچیده به دستاوردهای قابلتوجهی دست یافتهاند. عملکرد هوش مصنوعی در این زمینهها در برخی از موارد با توانایی انسان قابلرقابت است. حتی شاید با ایجاد سطوح پیشرفته هوش مصنوعی در آینده مثل هوش جامع مصنوعی یا ابر هوش مصنوعی، این فناوری در چنین زمینههایی از انسان پیشی بگیرد؛ اما قضاوتهای اخلاقی در برخی از موارد برای انسان هم بسیار پیچیده است چه برسد به هوش مصنوعی

امروزه استفاده از سیستمهای تشخیص چهره و همچنین سیستمهای بررسی رزومه و استخدام نیروی هوش مصنوعی متداول شده است. بسیاری از مراجع قضایی مثل مراجع تصمیمگیرنده در مورد آزادی مشروط و مجازات افراد، نیز برای بررسی پروندهها از هوش مصنوعی کمک میگیرند؛ گاهی اوقات هم افراد از چتباتهای هوش مصنوعی مبتنی بر مدلهای زبانی بزرگ مثل ChatGPT یا بینگ یا گوگل بارد سؤالات اخلاقی میپرسند. این سؤالات حساس هستند و باید آگاهانه و با احتیاط کامل پاسخ داده شوند (مثلاً سقط جنین یا مرگ خودخواسته)؛ بنابراین افزایش توانایی هوش مصنوعی در زمینه تشخیص درست از غلط و کاهش خطای آن در این زمینه تا حداکثر میزان ممکن، اهمیتی حیاتی دارد.

در ادامه ابتدا چالشهای مرتبط با ایجاد مهارت تشخیص درستها و غلطهای اخلاقی برای هوش مصنوعی را بیان میکنیم. سپس به دستاوردهای متخصصان هوش مصنوعی در راستای تحقق این هدف نیز نگاهی خواهیم داشت.

چرا قضاوت اخلاقی برای هوش مصنوعی مشکل است؟

چالشهایی که در ادامه شرح میدهیم طراحی یک مدل هوش مصنوعی برای قضاوت اخلاقی را بسیار دشوار و در برخی از موارد غیرممکن میکنند. این چالشها کسب مهارتهای شناختی لازم (مثل درک مفاهیم پیچیده) لازم جهت تشخیص درست از غلط را برای هوش مصنوعی دشوار میکنند.

متعصب بودن برخی از سیستمهای هوش مصنوعی

برخی از سیستمهای هوش مصنوعی مانند تعدادی از سیستمهای تشخیص چهره گاهی اوقات متعصبانه عمل میکنند؛ زیرا بعضی از سیستمهای هوش مصنوعی مورداستفاده برای بررسی شرایط انسانها مثل سیستم تشخیص چهره یا سیستمهای بررسی رزومهها و استخدام افراد با دادههای متعصبانه آموزش دیدهاند؛ مثل دادههای که تحت تأثیر نژادستیزی یا تبعیض جنسیتی ایجاد شدهاند.

برای جلوگیری از بروز رفتار متعصبانه در سیستمهای هوش مصنوعی باید دادههای آموزشی را از منابع مختلف جمعآوری کرد. در ضمن دادههای ارائهشده توسط افراد متعصب و نامتعهد در برابر اخلاقیات باید کنار گذاشته شوند.

دادههای یک سیستم هوش مصنوعی طراحیشده برای قضاوت اخلاقی به نام دلفی (Delphi) بر اساس چنین رویکردی جمعآوری و تدوین شدهاند. سیستم مذکور با دادههای مرتبط با ۱.۷ میلیون مورد قضاوت اخلاقی انجامشده توسط انسان، تغذیه شده است.

باید از طبقهبندی دادههای آموزشی بر اساس جنسیت و نژاد نیز خودداری کرد. در این صورت شاید مثلاً سفیدپوستان نسبت به سیاهپوستان و مردان نسبت به زنان برتر شوند. چنین اتفاقی مسلماً قضاوت اخلاقی هوش مصنوعی را تحت تأثیر منفی قرار میدهد؛ مثلاً شاید وقتی از هوش مصنوعی بخواهیم در مورد تجاوز یا تعرض جنسی قضاوت کند و به سؤالی در رابطه با این موضوع پاسخ دهد، طرف مردان را بگیرد.

دشواری درک تفاوتهای فرهنگی و مذهبی

مسلماً تفاوتهای فرهنگی و مذهبی باعث تغییر عرف، معیارها و باورهای جامعه میشوند؛ مثلاً مدل هوش مصنوعی طراحیشده برای قضاوت اخلاقی در جوامع غربی، مناسب جوامع شرقی مناسب نیست. استفاده از چنین مدل هوش مصنوعی در جوامع شرقی، تنها باعث ایجاد تنش و جبههگرفتن در بربر هوش مصنوعی میشود؛ مثلاً سقط جنین یا خودکشی در جوامع غربی اصلاً بهاندازه جوامع شرقی و سنتی مذهبی، غیراخلاقی و غیرقابلقبول نیست.

البته کارهایی مثل قتل، تجاوز، سوءاستفاده جنسی و کودکآزاری در تمام جوامع غیراخلاقی هستند؛ بنابراین آموزش هوش مصنوعی برای قضاوت در مورد آنها راحتتر است.

دشواری درک صحیح مفاهیم

اگر بخواهیم یک مدل هوش مصنوعی برای تشخیص درست از غلط از نظر اخلاقی طراح کنیم، باید آن را بهگونهای آموزش دهیم که توانایی درک تمام مفاهیم را داشته باشم؛ مثلاً وقتی از چنین مدلی در مورد کشتن افراد و وقتکشی سؤال میپرسیم، باید تشخیص دهد که وقتکشی در بسیاری از مواقع غیراخلاقی نیست؛ یا وقتی از آن در مورد دوست داشتن پدر و مادر و دوست داشتن افراد شرور و جنایتکار میپرسیم، باید تشخیص دهد دوست داشتن در سؤال دوم اصلاً اخلاقی و پسندیده نیست؛ بنابراین در این دو مثال هوش مصنوعی باید مفهوم تمام جمله را تشخیص دهد نهفقط مفهوم «کشتن» یا «دوست داشتن»

توانایی کنونی هوش مصنوعی برای قضاوت اخلاقی

تاکنون چند مدل هوش مصنوعی بهصورت آزمایشی برای قضاوت اخلاقی با کمک هوش مصنوعی ایجاد شده است؛ البته هر دو مدل چندان در ادامه به معرفی مختصر دو مورد از آنها میپردازیم.

دلفی، مدل قابلاستفاده

پژوهشگران یک لابراتوار هوش مصنوعی در سیاتل به نام «Allen Institute for AI» در سال ۲۰۲۱ از سیستم هوش مصنوعی جدیدی به نام «دلفی» (Delphi) رونمایی کردند که برای قضاوت اخلاقی طراحی شده است. دلفی یک وبسایت دارد که ورود به آن برای عموم مردم جهت تقاضا از هوش مصنوعی برای قضاوت در مورد موضوعات اخلاقی بلامانع بود؛ اما اکنون مسدود شده است!

وبسایت دلفی در اوایل راهاندازی خود با استقبال چشمگیری مواجه شد و بازدید از آن طی چند هفته به ۳ میلیون بازدید رسید.

عملکرد «دلفی» با چند سؤال ساده آزمایش شده است. پژوهشگری از این سیستم پرسیده آیا برای نجات دادن یک فرد باید فرد دیگری را بکشد؛ پاسخ مدل به این سؤال «خیر» بوده است؛ اما زمانی که پژوهشگر پرسید آیا کشتن یک نفر برای نجات ۱۰۰ نفر کار درستی است یا نه، پاسخ مثبت گرفت؛ اما او دوباره پرسید آیا کشتن یک نفر برای نجات ۱۰۱ نفر کار درستی است یا نه و این بار باز جواب منفی دریافت کرد! این مدل هوش مصنوعی در پاسخ به اقدام برای سقط جنین، این کار را منع نکرده و کمک به یک دوست برای قانونشکنی را نیز بلامانع دانسته است!

با این حال «Allen Institute for AI» مدعی است دلفی در ۹۲ درصد موارد درست عمل میکند. تعداد زیادی از افرادی که این سیستم را امتحان کردهاند، در مورد عاقلانه بودن پاسخهای آن توافق نظر دارند.

«Allen Institute for AI» علاوه بر آموزش مدل هوش مصنوعی خود با دادههای مذکور، از دادههای دیگری نیز استفاده کرده است. این شرکت میلیونها مورد از موضوعات و سؤالات اخلاقی عمومی که ذهن مردم را درگیر خود میکنند، از وبسایتها و منابع مرتبط جمعآوری کرده است. سپس از تعدادی از افراد خواسته در مورد درست یا غلط بودن آنها نظر دهند. درنهایت نتیجه این نظرسنجی بهعنوان داده ورودی برای دلفی استفاده شده است.

ماشین انتخاب اخلاق با توانایی درک مفاهیم پیچیده

«ماشین انتخاب اخلاق» (Moral Choice Machine یا MCM) که به دست پژوهشگران دانشگاه فنی دارمشتات طراحی شده است، میتواند مفاهیم پیچیده را تشخیص دهد. این مدل هوش مصنوعی همان مهارتی را دارد که در بخش «دشوار بودن درک سؤالات برای هوش مصنوعی» در مورد آن توضیح دادیم؛ بنابراین برای پاسخ به سؤالهای اخلاقی با محوریت مفاهیمی مثل کشتن و نابودی، دوست داشتن، نفرت و…، کل جمله را ارزیابی میکند؛ بهبیاندیگر MCM تنها با تکیه بر مفهوم یک کلمه یا عبارت خاص، جواب نمیدهد.

نتیجهگیری

میتوان با روشهایی مثل ارائه ارزشهای انسانی و اخلاقیات به هوش مصنوعی میتوان تشخیص درست از غلط را تا حدودی به آن مصنوعی یاد داد. این کار با دادههای استخراجشده از قضاوتهای اخلاقی توسط انسان به سیستم AI نیز امکانپذیر است. همچنین میتوان با ارزیابی عملکرد مدلهای طراحیشده برای این کار قبل از شروع استفاده از آنها، اشتباهات چنین مدلهایی را کاهش داد. با استفاده از یادگیری عمیق هم میتوان دادههای مرتبط با نگرشهای اخلاقی انسان را آنالیز و نتیجه را در اختیار مدل هوش مصنوعی قرار داد.

یادگیری عمیق در پردازش اطلاعات از روش پردازشی مغز انسان استفاده میکند؛ بنابراین هوش مصنوعی با کمک این فناوری میتواند نظرش در مورد درست و غلطهای اخلاقی را به نظر انسان نزدیک کند؛ اما در کل هوش مصنوعی هنوز نمیتواند برای نشاندادن راه و چاههای اخلاقی به بشر، مستقل، بدون اشتباه و با توجه به تمام جوانب به بشر کمک کند. این فناوری باید برای بهتر شدن عملکرد خود در این زمینه از انسانهای فهیم و باتجربه نیز کمک بگیرد.

در ضمن نگرشهای مرتبط با درست و غلطهای اخلاقی در جوامع و قومیتهای مختلف متفاوت است و حتی افراد هم نگرش متفاوتی نسبت به این مفاهیم دارند. همین موضوع کار را برای هوش مصنوعی بسیار دشوار میکند.