متاسفانه امروزه تصاویر و ویدیوهای ساختگی به معضل بزرگی برای دنیای رسانه تبدیل شده است. این معضل باعث شده حتی آنچه را که در تصاویر و ویدیوها با چشم خودمان میبینیم، نتوانیم با قاطعیت کامل قبول یا رد کنیم؛ مثلاً زمانی که ویدیویی را از سخنان غیر قابلانتظار رئیسی جمهوری را در رسانهای افشاگر میبینیم، بیشتر اوقات نمیتوانیم درمورد درست یا جعلیبودن آن مطمئن شویم؛ زیرا در سالهای اخیر ساختن چنین ویدیوهای جنجالی ساختگی کار چندان سختی نیست و ابزارهای هوش مصنوعی دیپ فیک آن را امکانپذیر کردهاند.

دیپ فیک (Deep fake) در یک جمله به معنای ساخت تصاویر و ویدئوهای ساختگی بسیار نزدیک به واقعیت با هوش مصنوعی است. این فناوری یکی از موارد سوءاستفاده از هوش مصنوعی برای اهداف مجرمانه و مخرب است. در ادامه بیشتر با دیپ فیک آشنا میشویم و راههای تشخیص تصاویر و ویدئوهای ساختگی ایجادشده با هوش مصنوعی را بیان میکنیم.

در فناوری دیپ فیک از تکنیکهای هوش مصنوعی برای شبیهسازی حرکات فیزیکی بدن، بخشها و ویژگیهای چهره و حتی صدا استفاده میشود. محتواهای دیپ فیک در بسیاری از موارد کاملاً نزدیک به واقعیت هستند و در نگاه اول تقریباً نمیتوانید به ساختگی بودن آنها پی ببرید.

برای جعل تصاویر و ویدئوها با فناوری دیپ فیک، محتواهای واقعی با الگوریتمهای هوش مصنوعی دستکاری و تغییرات موردنظر روی آنها اعمال میشود.

حتماً بهتازگی در اینستاگرام ویدئوهایی را دیدهاید که چهره فردی روی صورت فرد دیگری ظاهر میشود؛ مثلاً زمانی که فردی در حال صحبت است ناگهان چهره او به چهره یک سلبریتی تغییر میکند. گاهی اوقات هم در یک ویدئو چهره فرد در حال صحبت دائماً تغییر پیدا میکند و چهرههای متفاوتی را روی صورت او میبینیم. ایجاد چنین تغییر تعجببرانگیزی در ویدئوها نتیجه استفاده از فناوری دیپ فیک است.

فناوری دیپ فیک چگونه کار میکند؟

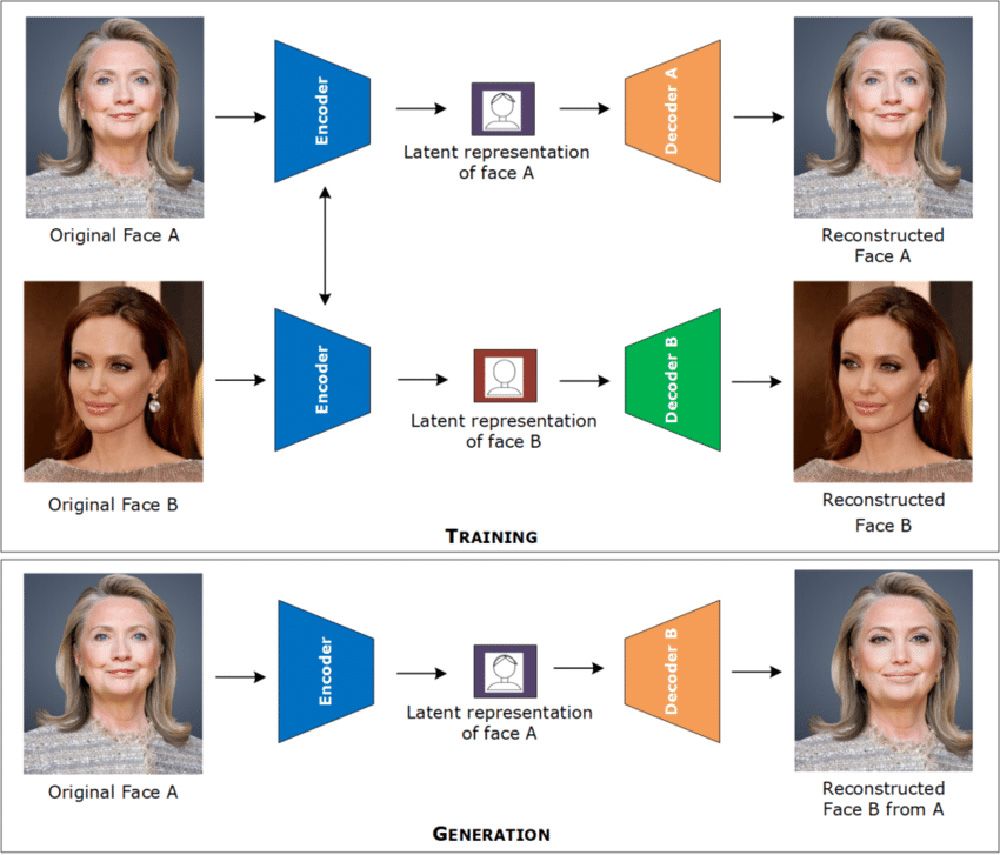

فرایند دیپ فیک در دو مرحله انجام میشود. ابتدا بخشهای چهرهای که قرار است تغییر داده شود و چهرهای که میخواهید آن را جایگزین نخستین چهره کنید، مثل دهان، دماغ و بینی با الگوریتمهای هوش مصنوعی شناسایی میشوند. پس از شناسایی بخشهای مختلف هر دو صورت، شباهتها بین دو صورت مشخص میشود. در مرحله دوم هوش مصنوعی میفهمد چگونه چهره دوم را جایگزین چهره اول کند و بخشهای مختلف آنها را با هم مطابقت دهد. در تصویر زیر میتوانید روند این فرایند را مشاهده کنید.

روش دیگری برای تولید تصویر دیپ فیک وجود دارد که در آن از یک سیستم هوش مصنوعی دوقسمتی استفاده میشود. در این سیستم یک قسمت به نام مولد تصاویر جعلی که واقعی به نظر میرسند، تولید میکند (مثلاً با قرار دادن چهره یک فرد روی بدن فرد دیگر). قسمت دیگر به نام تشخیصدهنده، مشخص میکند که تصاویر ایجادشده، ساختگی یا واقعی هستند. هرچه تشخیصدهنده در تشخیص تصاویر جعلی بهتر عمل کند، خروجی سیستم بیشتر به واقعیت نزدیک میشود.

چگونه محتوای دیپ فیک را تشخیص دهیم؟

دیپ فیک میتواند تهدیدی برای امنیت عمومی و پایبندی به اخلاقیات بهواسطه هوش مصنوعی باشد. بسیاری از مردم ناآگاه و سادهلوح آنچه را که میبینند و میشنوند، بدون تعلل باور میکنند. با سو استفاده از این فناوری میتوان اخبار و اطلاعات دروغین را از زبان افراد دارای اعتبار مثل مقامات دولتی یا سلبریتیهای اخلاقمدار و معتمد به مردم ارائه کرد. قطعاً وقتی مردم با گوش خود میشنوند که یک مقام دولتی یک سری اطلاعات و اخبار را بیان میکند، غافل از واقعیت شنیدههای خود را میپذیرند.

در برخی از موارد از تصاویر و ویدئوهای جعلی برای خدشهدار کردن اعتبار و آبرو یا تهمتزدن به افراد استفاده میشود؛ ساخت تصاویر و ویدئوهای مستهجن یا تشویش کننده اذهان عمومی مثالهایی از استفادههای مخرب از دیپ فیک هستند؛ دیپ فیک برای انجام فعالیتهای مجرمانه و مخرب زیر نیز ابزار خطرناکی محسوب میشود:

- جعل هویت

- کلاهبرداری در پلتفرمهای دیجیتالی

- شبیهسازی صدا یا تصویر افراد برای ورود به مکانهای حساس یا امنیتی یا ورود به پلتفرمهای دیجیتالی محافظتشده؛ مثل اپلیکیشنهای بانکی یا اپلیکیشنهای دربردارنده رمزهای عبور و اطلاعات حساس شخصی

- تهدید یک فرد برای اخاذی از او یا وادارکردن او به انجام یک کار

بنابراین اطلاع از روشهای شناسایی محتوای دیپ فیک اهمیت زیادی دارد. در ادامه با تعدادی از این روشها آشنا میشویم.

حالتهای غیرعادی در چهره یا بدن فردی در ویدئو

مثلاً اگر فرد در حال صحبت در ویدئو پلک نزند یا سر او مدت زیادی ثابت باقی بماند یا بدنش هیچ حرکتی نکند، بهاحتمالزیاد ویدئو جعلی است.

هماهنگنبودن حالات چهره و حرکات بدن فرد در ویدئو

همانطور گفتیم برای ساخت تصویر یا ویدئوی دیپ فیک، تنها چهره افراد با چهره دیگری جایگزین میشود؛ بنابراین مطابقت نداشتن حالات چهره با حرکتهای بدن و ژستهای بدن فرد در حال صحبت نشانه جعلی بودن ویدئو است.

کوتاهبودن ویدئو

آموزش الگوریتمهای هوش مصنوعی برای ایجاد یک ویدئوی جعلی طولانی باکیفیت و غیرقابلتشخیص با واقعیت، زمان زیادی میطلبد؛ بنابراین ویدئوهای دیپ فیک معمولاً چند ثانیه بیشتر نیستند.

تاربودن فضای داخل دهان

فناوری دیپ فیک برای شبیهسازی بخشهای مختلف دهان فرد در حال صحبت در یک ویدئو مثل دندانها، زبان و حفره دهان، خوب عمل نمیکند؛ بنابراین اگر به واقعی یا جعلی بودن یک ویدئو مشکوک شدید، با دقت به دهان فرد در حال صحبت نگاه کنید، چنانچه فضای داخل دهان تار باشد، ویدئو جعلی است.

توجه به جزئیات چهره

در ایجاد تصاویر و ویدئوهای جعلی به جزئیات ریز چهره توجهی نمیشود. وجود ویژگیهای زیر در تصویر چهره افراد، بهاحتمالزیاد نشانه جعلی بودن آنها است:

- تیرگی یا سایه کمرنگ در اطراف چشمها

- تارهای موی غیرواقعی

- بیش از حد صاف بودن پوست یا بالعکس وجود چینوچروکهای غیرطبیعی در آن

- خالهای ساختگی که غیرطبیعی بودن آنها کاملاً مشخص است

- رنگ غیرطبیعی لبها

سایر روشهای تشخیص محتوای دیپ فیک

- غیرطبیعی بودن حرکات لبها و ناهماهنگ بودن آنها با سخنان در حال بیان توسط فرد

- غیرطبیعی بودن صدای فرد در حال صحبت در ویدئو (در برخی از موارد کاملاً مشخص است که صدای فرد در حال صحبت در یک ویدئو، صدای واقعی او نیست(

- استفاده از نرمافزارهای تشخیص محتوای دیپ فیک مثل Sentinel و WeVerify یا وبسایتهای تشخیص چنین محتواهایی مثل deepware یا Deepfake detector . برای استفاده از این ابزارها و وبسایتها تنها کافی است ویدئو یا تصویری که به جعلی بودن آن مشکوک هستید، در آنها آپلود کنید. محتوای آپلود شده اسکن و نتیجه به شما اعلام میشود.